Webinaire avec Argus de l’Assurance

Le secteur de l’assurance fait partie des secteurs qui brassent de gros volumes de données. Le big data, associé aux algorithmes de plus en plus sophistiqués, transforme les métiers et bouscule les fondamentaux de l’assurance. Comment la data-science se décline-t-elle aujourd’hui dans la chaîne de valeur assurance : création de produits individualisés, prévention des risques, indemnisation des sinistres, lutte contre la fraude.

Ce webinaire tente d’apporter des éléments de réponses. Pour approfondir, vous pouvez participer aux formations suivantes:

- Lutte contre la fraude et data science

- Développer votre performance marketing avec la data-science

- Data-science : assurer la qualité de ses données

J’ai rédigé les réponses aux questions que vous avez posées. N’hésitez pas poser d’autres questions dans le fil de discussion en bas.

Questions réponses

Selon vous, quel est le sujet de data science qui intéresse particulièrement les assureurs en ce moment ?

Globalement, la data science intervient comme un outil de support au métier de l’assurance. En ce sens, la data science ne devrait pas créer des sujets intéressants pour les assureurs, mais ce sont plutôt les sujets qui préoccupent les assureurs qu’on essaie de traiter avec la data science.

Voici quelques sujets d’actualités :

- Qualité des données (Fichier des Véhicules Assurés, contrats non-réglés, et d’autres points liés à la Solvabilité 2)

- Automatisation des opérations ou RPA (Robotic Process Automation)

- Digitalisation et meilleure gestion des flux des données

- Analyse des dark data (OCR pour analyser les documents scannés, text-mining ou NLP pour exploiter les données textuelles)

- Assurance connectée

De façon générale, il y a d’autres sujets qui ne sont pas nouveaux, mais avec l’enrichissement des données et l’accès facilité aux données externes, les sujets suivants redeviennent d’actualité:

- Connaissance client: analyse des résiliations, segmentation des clients, cross-selling, up-selling, etc.

- Détection de fraudes

- Automatisation des opérations de souscription, d’indemnisation, de contrôle et d’audit.

Quelles sont les applications du text-mining dans votre domaine ?

Comme montré dans l’exemple pendant le webinaire, on peut transformer les textes en une matrice de caractéristiques (feature engineering), et on peut alors appliquer des algorithmes classiques.

Plus généralement, on peut parler du NLP (Natural Language Processing), et on peut citer les techniques de text classification, qui nous permettent d’analyser plusieurs documents envoyés par les clients et de les classifier automatiquement, et d’extraire les données pertinentes dans ces documents.

L’utilisation de chatbots peut également se révéler intéressante, car elle permet d’automatiser également la partie relationnelle du métier.

Quel est le ROI d’application de machine learning sur les cas concrets, comme la lutte anti-fraude ou la détermination de valeur client ?

En effet, pour tous les projets le ROI est important. A mon avis, on doit créer et tester des MVP (Minimum Viable Product ou Produit Minimum Viable) avant de faire des investissements lourds. En pratique, il n’est pas toujours facile de mesurer précisément le ROI.

Par exemple, la valeur client est une notion complexe. Si elle est bien modélisée et calculée, on peut l’utiliser pour sélectionner les clients qui devraient générer les bénéfices futurs les plus importants. Ainsi, le ROI réel n’est pas mesurable à court terme.

En revanche, pour la détection de fraude, le ROI est beaucoup plus facile à mesurer. En effet, plusieurs impacts financiers sont immédiats:

- si on arrive à détecter des cas de fraude à l’indemnisation, on peut refuser de payer les sinistres. Dans certains cas, on peut appliquer des RP.

- si on détecte des anomalies à la souscription qui entraînent de la sous-tarification, on peut aussi faire des avenants pour remettre les contrats en conformité avec le bon montant de primes. Les gains financiers sont aussi immédiats.

- d’autres bénéfices sont moins faciles à mesurer comme l’amélioration de l’image de marque, l’amélioration de l’expérience client, l’amélioration de la qualité des données.

Pour les deux premiers points, à l’aide des méthodes de data science, on peut rentabiliser les investissements en moins d’un an, grâce à deux aspects:

- augmenter le nombre de cas frauduleux détectés: au lieu d’avoir des gestionnaires qui travaillent manuellement sur des échantillons de dossiers, on peut automatiser la détection à tous les dossiers

- automatiser le processus de correction et de sanctions: quand le nombre de cas frauduleux devient trop important, on peut automatiser le traitement de certains dossiers

Concrètement, on peut prendre l’exemple de la détection de signatures falsifiées. En théorie, la détection n’est pas difficile en soi. On peut le faire manuellement: il suffit de sortir les documents dont le signataire est le même, ensuite, le gestionnaire va regarder et analyser les signatures de tous les documents. Parfois, il va trouver des signatures falsifiées (des imitations), parfois, il peut trouver des signatures qui sont exactement les mêmes (ce qui veut dire qu’elle sont été copiées collées).

Le gestionnaire peut le faire pour quelques dossiers, mais pas pour des milliers, voire des millions de documents. Etant donné que le nombre de cas frauduleux est faible, le ROI serait négatif. Maintenant, si un algorithme est construit pour faire ce travail, il est alors possible de trouver tous les cas frauduleux.

Ces progrès sont similaires aux changements qui ont eu lieu avec l’automatisation de la chaîne de production en construction automobile; aujourd’hui, avec les techniques de stockage de données, et les méthodes de machine learning ou de deep learning, il devient possible d’automatiser certains processus (comme la gestion des fraudes) en assurance qui étaient réalisés auparavant par les gestionnaires. On peut ainsi avoir un processus industrialisé qui comporte moins d’erreurs humaines, plus d’efficacité et de précision, avec un coût final moindre.

Comment jugez-vous qu’un modèle est trop compliqué pour être appliqué en production ? (question d’un data scientist)

Plusieurs contraintes doivent être prises en compte:

- temps d’exécution: la valeur raisonnable dépend de chaque situation: pour la tarification par exemple, il faudrait que ce soit presque instantané au moment où un client demande un devis. Pour la détection de fraude, ça devient variable, et ça dépend aussi de la disponibilité des gestionnaires pour traiter les dossiers (ou pour certains cas, il est possible d’automatiser les alertes).

- explicabilité du modèle: là aussi, le niveau d’explicabilité est différent. Pour la tarification, on n’a pas besoin forcément d’être explicite; mais pour la fraude, il faut donner des preuves factuelles.

Mais concernant la mise en production, je ne partirais pas des modèles pour prendre la décision, je regarderais plutôt si les résultats sont viables. En général, c’est possible de mettre en production des résultats issus de modèles simples

- pour la tarification par exemple, même si on parle beaucoup de l’intelligence artificielle, et de l’individualisation des primes, la réalité est que beaucoup d’assureurs et de mutuelles ont encore des méthodes de tarification simples qui fonctionnent. Au contraire, certains tentent d’innover avec des algorithmes compliqués.

- pour la détection des fraudes, c’est encore plus vrai. Si on arrive à détecter des fraudes avec de simples règles, on doit alors alerter les personnes concernées sans attendre.

Les techniques d’audit reposent habituellement sur des sondages. Ne faut-il pas désormais passer à des revues complètes de portefeuilles ou bases de données ? (question d’un directeur audit interne)

Selon mon expérience, le fait que l’audit, ou le contrôle se basent sur des sondages, c’est parce qu’on n’a pas le temps de faire l’analyse pour tout le portefeuille. Ainsi, si on arrive à automatiser le processus de contrôle, ou d’audit, on peut en effet passer à des revues complètes.

En pratique, il faudrait examiner chaque étape d’audit et de contrôle, et automatiser seulement ensuite. Selon les étapes de contrôles, le processus d’automatisation est plus ou moins complexe.

L’une des étapes d’audit qui nécessite des techniques d’analyse de données, c’est le contrôle des documents, plusieurs techniques peuvent être utiles:

- OCR: si le document de base est un document scanné

- Analyse des textes: plusieurs techniques peuvent être utilisés, et certaines ont été évoquées précédemment.

Si vous avez des étapes d’audit plus précises à automatiser, on pourra en parler.

Le problème de “boîte noire” a-t-il un impact sur l’aspect métier en assurance ? (question d’un étudiant data scientist)

Par “boîte noire”, on veut souvent parler de la difficulté à expliquer les résultats. Évidemment, de façon générale, si on n’arrive pas à expliquer les résultats, dans certaines situations, les résultats sont inutilisables, comme par exemple en détection de fraude.

Mais j’ai aussi remarqué qu’on dit parfois qu’un algorithme est une boîte noire, non pas parce qu’on ne sait pas expliquer les résultats, mais parce qu’on on n’en connaît pas le principe.

On peut prendre un exemple simple: la division euclidienne. Presque tout le monde sait comment faire la division euclidienne à la main. Mais avec la calculatrice, c’est plus rapide. Ainsi, personne ne dira que la calculatrice est une boîte noire pour la division euclidienne.

En revanche, quand il s’agit du calcul de la racine carrée, certains n’ont aucune idée de la manière dont le calcul peut être fait à la main. Ainsi, la calculatrice pourrait paraître comme une boîte noire pour ces personnes.

Pour revenir aux algorithmes de machine learning, le principe de tous les algorithmes est connu, et établi par des chercheurs. Si vous ne connaissez pas comment fonctionnent des algorithmes, il ne faut pas pour autant dire que c’est une boîte noire quand vous les utilisez (un peu comme quand vous utilisez une calculatrice pour les racines carrées).

Les calculs complexes effectués par les modèles sur les données sont vus comme une boîte noire car on n’a pas une relation simple entre les données d’entrée, et les résultats de sortie. Dans ce cas, un simple arbre de décision peut être vu comme une boîte noire, et encore plus pour une Forêt aléatoire. Cependant, il ne faut pas oublier que le principe de calcul est simple, et tous les calculs effectués sont auditables en théorie.

Pourtant ce sont de simples règles qui sont utilisées dans un arbre de décision, et pour une forêt aléatoire, c’est un ensemble d’arbres de décision, construit sur des échantillons de données et de variables explicatives (au lieu de prendre la totalité pour un arbre simple) qui est utilisé.

Parfois encore, certains utilisent le terme de “boîte noire” pour dire qu’ils n’ont pas confiance dans les résultats qui sont produits par ces algorithmes. Là aussi, il y a une différence entre expliquer les résultats de façon explicite, et valider les résultats. Pour ce dernier on peut utiliser la validation croisée.

Pour l’interprétabilité des résultats en sortie des algorithmes, je vous invite à lire cet article: “Why Should I Trust You?”: Explaining the Predictions of Any Classifier, à l’origine de Local Interpretable Model-agnostic Explanations ou LIME.

Est-ce que la data science a tendance à complexifier les modèles ? (question d’un manager connaissance client en assurance)

La data science est un outil. Comme tous les outils, ils font ce qu’on leur demandent. Ainsi, la question pourrait plus être: est-ce que les gens ont tendance à utiliser la data science pour complexer les modèles?

J’aurais tendance à dire que ceux qui ne connaissent pas bien le principe d’utilisation des outils, et les objectifs des modèles ont tendance à complexifier des modèles, ce qui devient alors une sorte de bouclier en cas de questions.

Et les dialogues deviennent:

- Pouvez-vous expliquer vos modèles?

- Ah vous savez, c’est très compliqué.

- …

En pratique, je pense qu’il faut penser la solution à partir de la problématique:

- On doit dans un premier temps identifier le fond du problème (par exemple, pour la connaissance client, pourquoi vous souhaitez mieux connaître vos clients ? pour mieux leur proposer des produits nouveaux, ou pour améliorer l’efficacité d’une campagne marketing, ou pour mieux détecter le potentiel de résiliation ? Selon la question posée, les solutions peuvent être complètement différentes.)

- On doit simplifier au maximum le problème initial (on parle aujourd’hui beaucoup de la notion de “valeur client”. Beaucoup de problématiques de connaissance client peuvent faire partie des composantes de cette valeur.)

- On doit diviser un problème complexe en un ensemble de petits problèmes plus simples (La notion de “valeur client” est complexe. Pour cela , on doit calculer les composantes séparément: probabilité de résiliation, élasticité prix, multi-équipement, parrainage, etc.)

Lors de la construction de la solution, il faut aussi faire au plus simple. La décision d’investir dans une solution plus complexe ou non dépendra du ROI. Pour reprendre l’exemple de la valeur client, si on veut prendre en compte la résiliation de façon globale, on n’a pas besoin de modèle individualisé. Le modèle est simple, mais pas suffisamment précis pour optimiser les gains au niveau individuel.

Quelle est la principale différence entre le data mining et la data science ? Comment savez-vous qu’un assuré a fraudé dans le domaine des assurances? (question d’un étudiant data scientist)

En ce moment, il y a beaucoup de débats sur les définitions de différents termes tels que: data mining, machine learning, data science, intelligence artificielle, modèle prédictif, big data.

Il y a une réponse vue sur internet que j’aime bien:

- Data science: analyse des données vue par les statisticiens de la Silicon Valley

- Machine learning: analyses des données vue par les praticiens de l’intelligence artificielle

- Data-mining: analyses des des données vue par les gestionnaires des bases de données

- Statistique appliquée: analyses des données vue par les statisticiens

- Mathématiques appliquées: analyses des données vue par les mathématiciens

- Infographie: analyses des données vue par les marketeurs

- Data journalisme: analyses des données vue par les journalistes

- Econométrie: analyses des données vue par les économistes

- Bioinformatique: analyses des données vue par les biologistes

Pour la deuxième question, c’est une question qui a une importance opérationnelle primordiale. En effet, avec l’analyse des données, on peut seulement avoir des soupçons de fraude, et ensuite, c’est la travail des juristes et des avocats pour savoir si l’assuré a vraiment fraudé.

Pour la comparaison de modèles, quels sont les indicateurs les plus pertinents et les plus utilisés ? (question d’un alternant chez Allianz)

A mon avis, il faudrait choisir l’indicateur en fonction du problème à résoudre. Ensuite cet indicateur pourra ainsi aider à améliorer les modèles.

Les indicateurs ne sont donc pas là pour comparer les modèles, mais pour comparer les résultats en sortie des modèles. Les modèles sont donc optimisés pour ces indicateurs.

On peut citer les indicateurs les plus fréquents, selon les types de problèmes:

- classification: précision et rappel, F-score, AUC

- régression: erreur-type (RMSE ou Root Mean Squared Error), erreur absolue moyenne (MAE ou Mean Absolute Error), log loss

Mais il est important de relier ces indicateurs à la réalité opérationnelle. Par exemple, pour la détection de fraudes, on peut dire que c’est un problème de classification, et utiliser l’AUC pour mesurer la performance des modèles. Cependant si on ne peut pas traiter l’ensemble des cas frauduleux, il serait plus pertinent de fixer un seuil pour le nombre dossiers, et calculer le taux de précision pour les dossiers sélectionnés. Toutefois les dossiers n’ont pas tous le même impact financier, alors on devrait plutôt prendre en compte l’impact financier. Ainsi, on peut utiliser la somme des gains financiers pour mesurer la performance de ce problème de classification.

Dans un projet de data science comme dans tous les projets, les enjeux de ressources (humaines) comme de délai sont essentiels. Quel est pour vous le dimensionnement d’un équipe Data, en listant notamment les compétences nécessaires, ainsi que le temps de mise en œuvre (du moment où l’on pose la problématique jusqu’à la livraison d’un outil opérationnel), ou a minima d’un poc ? (question d’un directeur technique en assurances)

Je n’ai pas beaucoup d’expériences dans la gestion de gros projets, ou dans la gestion d’un nombre importants de personnes. Mais je peux vous répondre selon mon expérience à plusieurs points importants.

De façon générale, il faudrait définir le nombre de personnes à partir des problématiques, donc tout dépend des projets. Cela a l’air évident, mais cela veut dire qu’on connaît bien les problématiques et les solutions potentielles à explorer.

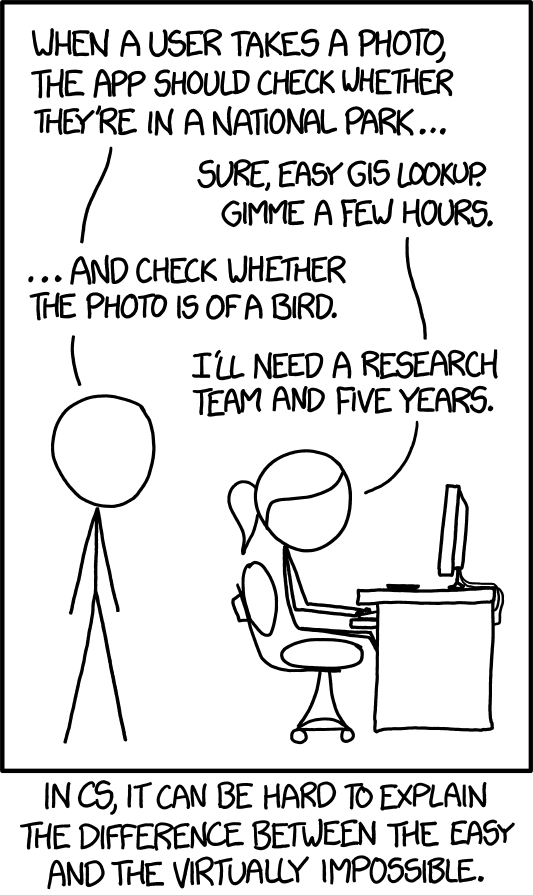

Source de l’image: https://imgs.xkcd.com/comics/tasks_2x.png

Concernant les compétences, il y a beaucoup de discussions sur internet à ce sujet, globalement, je les résumerais autour de trois axes :

- manipulation et gestion des bases de données (collecte, stockage)

- construction des algorithmes avec une bonne connaissance des théories

- connaissance métier

Pour revenir au nombre de personnes nécessaires, si une personne a les trois compétences, elle pourrait gérer un projet seule:

- poser la bonne question métier

- chercher les données nécessaires

- résoudre le problème et donner les interprétations et les conclusions pertinentes

Pour la gestion du projet plus concrètement,

- je ne suis pas fan de la notion de POC. Pour revenir à l’image xkcd, quand on dit “faire un POC”, c’est comme si on ne sait pas du tout si un projet pourrait apporter une solution viable, alors qu’on devrait le savoir dès le départ.

- je suis plus MVP (Produit minimum viable ou Minimum Viable Product). On doit d’abord réfléchir à la solution à partir de la problématique concrète, et proposer d’abord une solution très simple. Puis, au fur et à mesure, on utilise des techniques plus sophistiquées pour des résultats de plus en plus performants.

Dans le cas des algorithmes de machine learning non supervisés, quelle sont les métriques que vous utilisez pour mesurer la performance/pertinence de vos résultats, en particulier en détection de fraudes ? (question d’un data scientist)

Il y a un mélange de plusieurs notions:

- pour un apprentissage non supervisé, les résultats sont produits grâce à une métrique. Donc la notion de pertinence d’un algorithme d’apprentissage non supervisé est intrinsèque à la métrique choisie.

- les fraudes sont complexes, les métriques choisies dépendent du type de fraude, ou de la fraude étudiée.

- on choisit également une métrique en fonction de ce qu’on veut étudier.

Existe-t-il des techniques de machines learning ou deep learning qui remplacent le calcul stochastique classique des IBNR ? (question d’un data scientist senior)

Comme tous les outils, les techniques de machine learning ou de deep learning résolvent des problèmes spécifiques et adaptés.

Ainsi je commencerai par identifier les problèmes:

- Quelles sont vos données?

- Quelles valeurs cherchez-vous à estimer?

Si vous avez juste un triangle de sinistres, à mon avis, vous ne pourrez pas utiliser des méthodes de machine learning car le volume de données n’est pas suffisant.

Ce serait un peu comme essayer de trouver une “bonne méthode” pour calibrer une loi statistique avec 5 points.

Pour une première tentative d’application, quelle est l’outil que vous suggéreriez à un débutant, ayant un budget limité ? (question d’un analyste senior en assurances)

Tout dépend de ce que vous connaissez déjà. Et il y a beaucoup de choses dans votre question:

- application: quelle application souhaitez-vous faire ? c’est pour un projet d’entreprise, ou juste pour un exemple ? Si c’est juste un exemple, il y a des exemples simples pour un grand nombre d’algorithmes: arbre de décision, régression linéaire, classification naïve bayésienne, etc.

- outil: si vous ne connaissez pas déjà un outil de programmation, vous pouvez utiliser Excel, pour une première tentative. Sinon R est simple pour débuter.

- budget limité: pour un projet d’entreprise, ou pour l’apprentissage personnel, il y a beaucoup de ressources qui sont libres d’accès sur internet.

Comment peut-on donner une explication du modèle dans les techniques black box tel que SVM/ Réseaux de neurones …? (question d’un data scientist)

La notion de “boîte noire” a été précédemment expliquée.

- S’il s’agit de la compréhension du principe, le SVM ou le réseau de neurones ne sont pas des boîtes noires.

- Pour l’interprétabilité des résultats issus de ces algorithmes, c’est assez simple à comprendre, surtout en faible dimension.

De façon intuitive et simpliste:

- SVM: construire un hyperplan pour séparer des points de plusieurs catégories (en utilisant des kernels, c’est possible de traiter des problèmes non-linéaires), et en dimension 2, on construit une droite.

- Réseau de neurones: construire plusieurs couches de régresseurs logistiques, donc pour le réseau de neurones le plus simple est une régression logistique.

Comment justifiez-vous de la qualité de vos modèles dans un domaine qui ne supporte pas les risques ? (question d’un stagiaire data scientist en télécommunications)

Il faudrait préciser la nature du risque avant. S’il n’y a pas du tout de risque, pour moi, il n’y a pas besoin de modèle. Je travaille dans l’assurance, et c’est un métier de gestion de risques. Donc les risques sont partout, et on essaie de les maîtriser à plusieurs niveaux.

Je vois que vous êtes en télécommunications, je n’arrive pas à imaginer un exemple concret dans ce domaine.

A votre avis, pourquoi le comportement humain est-il si difficile à prédire ? (question d’un ingénieur data)

Parce que l’homme est un être sensible, et complexe, qui, en plus, vit dans un monde complexe, rempli d’autres hommes, complexes.

Avant d’aller plus loin, il faudrait définir un peu plus spécifiquement le terme “comportement humain”.

De façon générale, il faudrait analyser les questions de prédiction selon les angles suivants

- Données: a-t-on les données pertinentes pour la variable à prédire ?

- Modèles: est-ce que le modèle est assez pertinent ?

D’après votre expérience, quel est le meilleur modèle pour détecter de la fraude (en non supervisé) , les nouveaux cas de fraudes ? (question d’un étudiant data scientist)

Les fraudes sont de plusieurs types, donc pour chaque type de fraude, les modèles sont différents. Et selon les données disponibles, les approches sont différentes ainsi que les modèles.

De façon générale, on ne doit pas forcément poser la question selon cet angle: quel est le meilleur modèle? A mon avis, la question qui a beaucoup plus de valeur c’est: quel est précisément mon problème, qu’est-ce que je cherche à faire? Ensuite, je teste un ensemble de modèles.

On peut citer quelques exemples de détection de fraudes avec des algorithmes d’apprentissage non-supervisé, qui nécessitent des techniques complexes et différentes:

- Détection de profils atypiques de clients

- Si on a des indicateurs numériques, on peut utiliser k-means.

- Dans certains cas, on peut utiliser k-medians pour être moins sensible aux anomalies statistiques.

- Si les données sont catégoriques, on peut utiliser k-modes

- Détection des anomalies dans les documents ou des documents atypiques (la situation peut être complexe, comme montrée dans l’exemple discuté pendant le webinaire)

- On peut faire des regroupements hiérarchiques des textes

- On peut faire des prédictions de topics ou de tags

- Clustering des signatures, et détection des falsifications

Site internet de Kezhan SHI